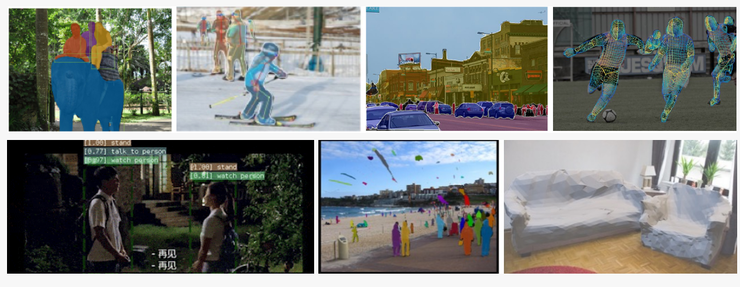

近日,F(xiàn)acebook AI 宣布開源 SlowFast,一個(gè)在 CVPR 2019 上的 AVA 視頻檢測挑戰(zhàn)賽中排名第一所用的模型。這一開源旨在進(jìn)一步提高系統(tǒng)識別與分類視頻內(nèi)容的能力,并改善視頻個(gè)性化推薦應(yīng)用。

SlowFast 是一個(gè)新型視頻識別方法,它可以模仿靈長類視覺中的視網(wǎng)膜神經(jīng)運(yùn)作原理,同時(shí)以慢速幀頻和快速幀頻提取視頻中的有效信息,從而提高動作分類及動作識別效果。與其他方法相比,SlowFast 的整體計(jì)算復(fù)雜度更低,準(zhǔn)確度更高。

Slow?Or Fast?

第一眼看到 SlowFast 時(shí),肯定有人會糾結(jié)這個(gè)模型到底是快,還是慢呢?但其實(shí)它的名稱正是源于它的實(shí)現(xiàn)原理,即通過兩條路徑——Slow 路徑和 Fast 路徑,同時(shí)以慢速和快速的幀速率,從視頻中提取信息來改進(jìn)動作分類和動作檢測。因此,它既快又慢。

具體而言,這兩條路徑由側(cè)連接(lateral connection)進(jìn)行融合。一條專注于處理可以在低幀速率下觀看的類別語義(如:顏色、紋理和目標(biāo)),它以低幀率運(yùn)行,刷新速度緩慢,旨在捕獲圖像或幾個(gè)稀疏幀提供的語義信息;而另一條路徑則尋找在以較高幀速率顯示的視頻中更容易識別的快速變化的運(yùn)動(如:鼓掌、揮手、搖頭、走路或跳躍),它的刷新速度快、時(shí)間分辨率高,用于捕獲快速變化的動作。

可盡管有兩條路徑,該模型的體量卻很輕,只占總計(jì)算資源的 20% 左右。這是因?yàn)榈诙€(gè)路徑通道較少,處理空間信息的能力較差,但這些信息完全可以由第一個(gè)路徑以一種簡單的方式來提供。

SlowFast 靈感之源

正常來講,很少有將兩種完全相反的概念融合為一體的模型;但于 SlowFast 而言,這一方法在很大程度上,受到靈長類視覺系統(tǒng)中視網(wǎng)膜神經(jīng)節(jié)細(xì)胞的生物學(xué)研究的啟發(fā)。

研究發(fā)現(xiàn),在靈長類的視覺系統(tǒng)中,約 80% 為是 P 細(xì)胞(P-cells),約 15-20% 是 M 細(xì)胞(M-cells)。M-cell 以較高的時(shí)間頻率工作,對時(shí)間變化更加敏感,但對空間細(xì)節(jié)和顏色的感知很弱;P-cell 則提供良好的空間細(xì)節(jié)和顏色,同時(shí)它的時(shí)間分辨率較低。

SlowFast 框架正是與此類似:

- 該模型有兩條路徑,分別以低時(shí)間分辨率和高時(shí)間分辨率工作;

- Fast 路徑用于捕捉快速變化的運(yùn)動,但空間細(xì)節(jié)較少,類似于 M-cell;

- Fast 路徑為輕量級,類似于較小比例的 M-cell。

Facebook AI 也希望通過對這些關(guān)系的介紹,能夠啟發(fā)更多用于視頻識別的計(jì)算機(jī)視覺模型。

SlowFast 進(jìn)展

通過合理的快慢分工,SlowFast 比之前的視頻識別系統(tǒng)都更加輕量級。目前,F(xiàn)acebook AI 已經(jīng)在四個(gè)主要的公共基準(zhǔn)數(shù)據(jù)集上建立了一個(gè)新的技術(shù)狀態(tài)。通過分析不同速度下的原始視頻,這一方法還可以使 SlowFast 網(wǎng)絡(luò)從本質(zhì)上進(jìn)行分治 (Divide-and-conquer)。

每個(gè)路徑都利用其在視頻建模中的特殊優(yōu)勢,Slow 路徑以每秒兩幀(fps)的速度處理最初刷新為每秒 30 幀的視頻片段,在這一速度下,物體或人的顏色、紋理或身份等特征也不會改變;同時(shí) Fast 路徑在相同的原始視頻剪輯上運(yùn)行,但是在更高的幀速率下——給定 30 fps 的鏡頭,該路徑也可能以 16 fps 的速度處理它,這些更快的刷新速度允許更好地理解視頻中正在發(fā)生的運(yùn)動類型。

這一設(shè)置的最主要優(yōu)點(diǎn)在于提高 Fast 通道時(shí)間建模能力的同時(shí),也降低了 Fast 通道的信道容量,最終呈現(xiàn)的是一個(gè)系統(tǒng)的整體計(jì)算復(fù)雜度和精度比其他更高,計(jì)算量更大的算法。

令人振奮的成果

Facebook AI 在 Kinetics-400、Kinetics-600 和 Charades 數(shù)據(jù)集,以及 Ava 數(shù)據(jù)集上檢測了 SlowFast 的實(shí)際能力。實(shí)驗(yàn)結(jié)果表明該模型在視頻動作分類及檢測方面性能非常強(qiáng)大,SlowFast 網(wǎng)絡(luò)比預(yù)先訓(xùn)練的系統(tǒng)更加精確,包括在動力學(xué)和特性上都比最新的模型高出幾個(gè)百分點(diǎn):

- 在沒有使用任何預(yù)訓(xùn)練的情況下,在 Kinetics 數(shù)據(jù)集上實(shí)現(xiàn)了 79.0% 的準(zhǔn)確率;

- 在 AVA 動作檢測數(shù)據(jù)集上也實(shí)現(xiàn)了 28.3 mAP 的當(dāng)前最佳水準(zhǔn),這一基于最慢速度的系統(tǒng)還在 CVPR 2019 上的 AVA 視頻檢測挑戰(zhàn)賽中取得了第一的優(yōu)秀成績。

SlowFast 應(yīng)用前景

從已有的信息來看,F(xiàn)acebook AI 并沒有使用 SlowFast 或文中提到的公共數(shù)據(jù)集來訓(xùn)練生產(chǎn)模型,但是這一研究可以在視頻分析方面有廣泛的應(yīng)用,包括:改進(jìn)系統(tǒng)如何自動識別、分類視頻內(nèi)容,以及視頻推薦等應(yīng)用。

同時(shí),在視頻檢測方面的進(jìn)展也有利于幫助公共平臺尋找和刪除有害視頻,也包括為視頻個(gè)性化提供更好的推薦建議。

原文參考:

http://t.cn/Ai1OPFAr

GitHub 地址:

https://github.com/facebookresearch/SlowFast

論文鏈接:

https://arxiv.org/pdf/1812.03982.pdf?

來源 | 雷鋒網(wǎng) AI 開發(fā)者

作者 | 楊鯉萍